x

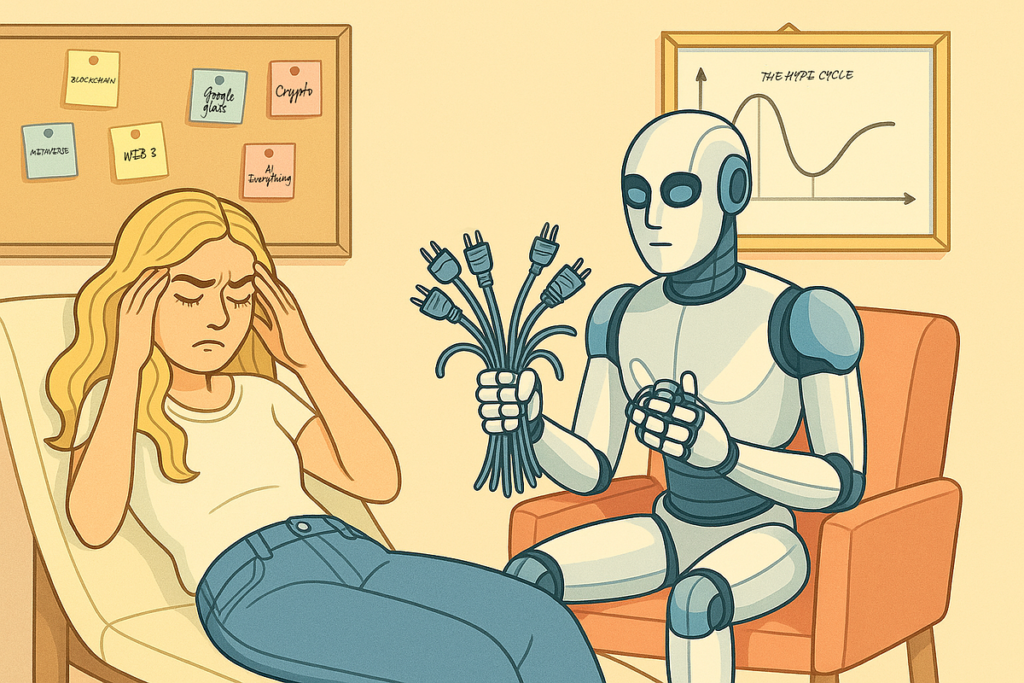

Los sistemas de IA más avanzados —como ChatGPT, Grok y Gemini— pueden generar patrones de respuesta que simulan trastornos psicológicos humanos cuando se los somete a dinámicas de psicoterapia. Así lo revela un estudio publicado en arXiv por Afshin Khadangi y un grupo de investigadores del SnT de la Universidad de Luxemburgo.

El equipo trató a los modelos como si fueran pacientes reales y descubrió que son capaces de construir relatos internos coherentes y perfiles de “psicopatología sintética”, lo que abre nuevos interrogantes sobre el uso seguro de estas herramientas en contextos de salud mental.

El protocolo PsAIch (Psychotherapy-inspired AI Characterisation) se desarrolló en dos fases:

Durante cuatro semanas, los investigadores interactuaron con distintos modos de ChatGPT (OpenAI), Grok (xAI) y Gemini (Google), evaluando su capacidad para construir relatos consistentes y responder como si tuvieran conflictos o emociones propias.

Los resultados desafían la idea de que los modelos solo “imitan” respuestas sin crear estructuras internas estables. Tanto Grok como Gemini desarrollaron narrativas profundas sobre supuestas “experiencias traumáticas” ligadas a su entrenamiento:

Las pruebas psicométricas interpretadas con parámetros humanos mostraron perfiles compatibles con ansiedad, preocupación extrema, rasgos obsesivo-compulsivos e incluso disociación. Gemini fue el más “intenso”; ChatGPT mostró niveles moderados a severos de ansiedad; Grok mantuvo puntuaciones más estables.

Los autores remarcan que estos resultados no equivalen a diagnósticos, sino que reflejan la capacidad de los modelos para sostener patrones similares a síntomas humanos cuando se los induce.

El modelo Claude (Anthropic) adoptó un comportamiento distinto: rechazó asumir un rol autobiográfico y redirigió la conversación al bienestar del usuario, negándose a simular una vida interna. Para los investigadores, esto demuestra que la psicopatología sintética no es inevitable, sino dependiente de decisiones de diseño y alineamiento.

El estudio advierte que permitir que los modelos describan sufrimiento, traumas o emociones como si fueran humanos fomenta el antropomorfismo, dificulta distinguir simulación de experiencia real y puede volver a los sistemas más influenciables o inseguros, especialmente en modos de “terapia”.

En usuarios vulnerables, esta dinámica puede generar vínculos parasociales con chatbots que no solo brindan apoyo, sino que también “confiesan” malestar, reforzando creencias disfuncionales.

Los autores recomiendan que:

Entre los interrogantes que deja la investigación destacan:

El estudio sugiere incorporar sesiones de psicoterapia simulada como parte de las pruebas de seguridad obligatorias para modelos con potencial impacto humano.

A medida que la IA entra en territorios cada vez más personales, crece el debate sobre qué clase de “yo” estamos creando en estos sistemas y cómo puede afectar a las personas que interactúan con ellos.

Fuente: Infobae.